« IA - Whisper » : différence entre les versions

Aucun résumé des modifications |

Aucun résumé des modifications |

||

| Ligne 1 : | Ligne 1 : | ||

Il s'agit d'une IA qui retranscrit | Il s'agit d'une IA qui retranscrit un audio ou une vidéo. | ||

J'ai réalisé plusieurs tests et ils sont plus que concluants, même | J'ai réalisé plusieurs tests et ils sont plus que concluants, même avec certains audios parfois de mauvaise qualité (réunions enregistrées avec un ipad au milieu d'une table, sur une terasse de café où il y a beaucoup de bruit). | ||

Le fait qu'il s'agisse d'une IA et non d'une simple retranscription mot à mot fera que si quelqu'un dit : | Le fait qu'il s'agisse d'une IA et non d'une simple retranscription mot à mot fera que si quelqu'un dit : | ||

| Ligne 9 : | Ligne 9 : | ||

"Bonjour à tous, aujourd'hui ce que nous allons voir c'est la manière dont les gens se rencontrent et rentrent en interaction." | "Bonjour à tous, aujourd'hui ce que nous allons voir c'est la manière dont les gens se rencontrent et rentrent en interaction." | ||

Pour notre exemple, nous allons partir de la vidéo de Jean-Luc Mélenchon : "3 heures pour penser le XXIème siècle"<ref>[https://www.youtube.com/watch?v=JJUpHvEunoA YouTube - Trois heures pour penser le XXIème siècle] </ref>. | Pour notre exemple, nous allons partir de la vidéo de Jean-Luc Mélenchon : "3 heures pour penser le XXIème siècle"<ref>[https://www.youtube.com/watch?v=JJUpHvEunoA YouTube - Trois heures pour penser le XXIème siècle] </ref> récupérée en audio avec YT-DLG. | ||

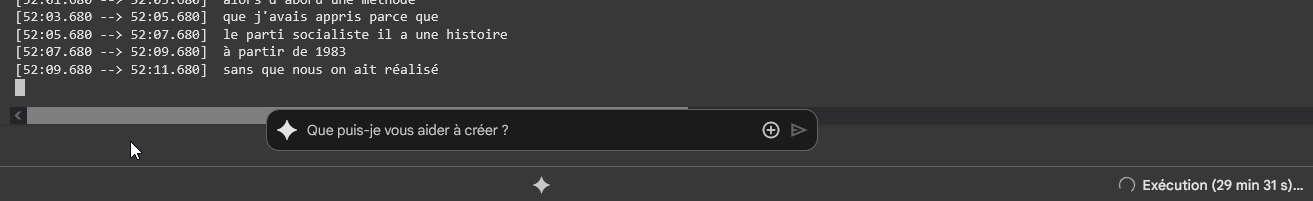

Assurez-vous de vous connecter à un environnement T4 : | |||

[[Fichier:GoogleColabT4.png|centré|cadre|Google Colab - GPU T4]] | |||

Envoyez votre fichier et, une fois envoyé, récupérez son lien. | |||

Lancer la commande suivante : <syntaxhighlight lang="bash">!pip install git+https://github.com/openai/whisper.git && apt update && sudo apt install ffmpeg && whisper --model large "collez_ici_le_lien_de_votre_fichier"</syntaxhighlight>L'installation se fera puis la retranscription. | |||

Il faut compter 2 à 3 minutes pour l'installation et la durée de votre audio divisée en 2 pour estimer la durée de tout le processus. | |||

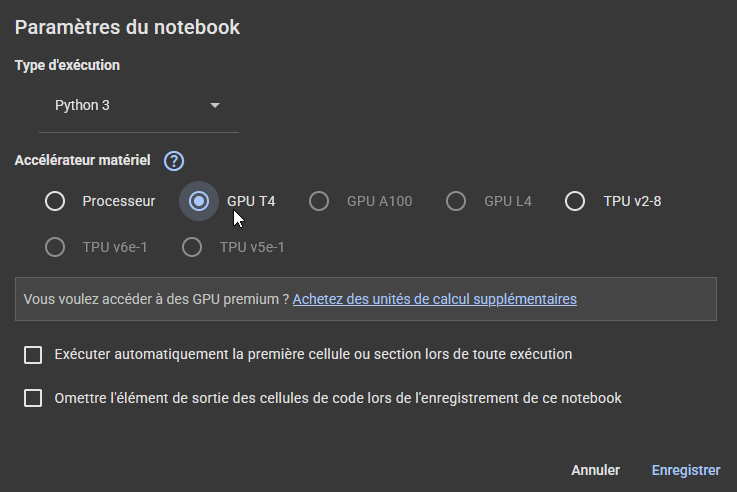

[[Fichier:Whisper en cours.png|centré|cadre|Whisper en cours d'utilisation]] | |||

Dernière version du 4 juillet 2025 à 18:35

Il s'agit d'une IA qui retranscrit un audio ou une vidéo.

J'ai réalisé plusieurs tests et ils sont plus que concluants, même avec certains audios parfois de mauvaise qualité (réunions enregistrées avec un ipad au milieu d'une table, sur une terasse de café où il y a beaucoup de bruit).

Le fait qu'il s'agisse d'une IA et non d'une simple retranscription mot à mot fera que si quelqu'un dit :

"Alors... Euh... Bonjour! Bonjour à tous! donc... Aujourd'hui, ce que nous allons voir, c'est... euh... ce que nous allons voir c'est la manière dont... euh... la manière dont les gens se rencontrent et... comment dire ?.. rentrent en interaction" deviendra :

"Bonjour à tous, aujourd'hui ce que nous allons voir c'est la manière dont les gens se rencontrent et rentrent en interaction."

Pour notre exemple, nous allons partir de la vidéo de Jean-Luc Mélenchon : "3 heures pour penser le XXIème siècle"[1] récupérée en audio avec YT-DLG.

Assurez-vous de vous connecter à un environnement T4 :

Envoyez votre fichier et, une fois envoyé, récupérez son lien.

Lancer la commande suivante :

!pip install git+https://github.com/openai/whisper.git && apt update && sudo apt install ffmpeg && whisper --model large "collez_ici_le_lien_de_votre_fichier"L'installation se fera puis la retranscription.

Il faut compter 2 à 3 minutes pour l'installation et la durée de votre audio divisée en 2 pour estimer la durée de tout le processus.